初めて聞くワードで意味が分からない方が多いと思いますが、robots.txt を知るにあたって、Googleの検索システムについて知っておく必要があります。

別の記事でまとめていますので、そちらの方をみてからの方がわかりやすいと思います。

robots.txt とは

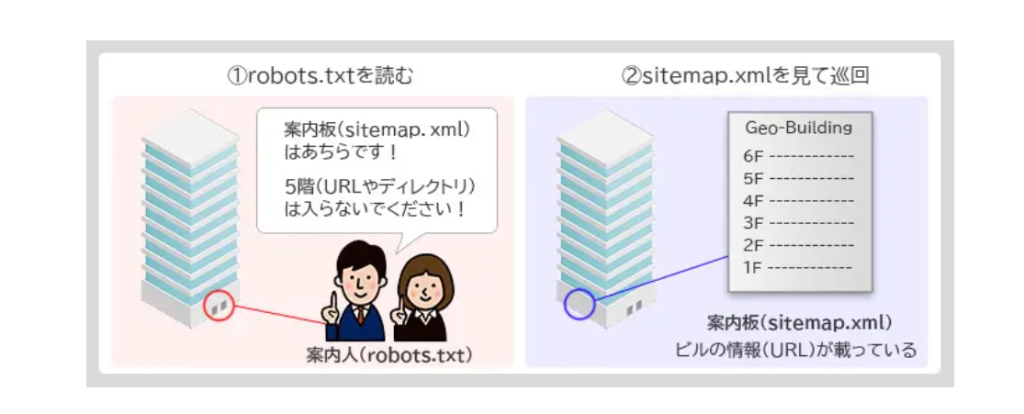

クローラーに検出されたくないページを検出させないようにするものです。

robots.txtを使うことで、サイト内の質の低いコンテンツをブロックし、重要なページを認識させるようクローラーを制御することができます。

robots.txtファイルがなくても、ページはインデックスされます。

クローラーはサイトの他の部分をクロールする前にまずこのファイルを検索します。書き間違いに注意すれば、設定して損はないものです。

すごくわかりやすい図がこちら

このファイルがあると、インデックスさせたいページ、させたくないページを設定することができます。

設置方法

① テキストファイルを作成

テキストファイルを作成します。

名前は「robots.txt」にします。

テキストの中に書く項目は、下記にある通りです。必要なものを記入します。

① User-Agent:*(必須) :どのクローラーの動きを制御するか記入。基本的には*(すべてのクローラー )でOK。Googlebotのみ制御する場合は「User-Agent:Googlebot」と記入。

② Disallow:/〇〇(パス)/ :アクセスを制御するファイル。無記入だとすべてクロールの対象。Disallow:/だとすべてブロック

クロールを制御するだけなので、検索結果にはでます。

検索結果に出したくない場合は、noindexタグを使用

この場合Disallow:には記載しない(noindexを見つけることができず、結果に出てしまうため)

③ Allow: /〇〇(パス)(書かなくてOK) :アクセスを許可するファイル。Allow: /だとすべて許可。ブロックしたファイルのなかで一部許可したい場合などに使用。

④ Sitemap:https://○○○/sitemap(書かなくてもOK) :これを記入するとサイトマップを積極的に読んでもらえる

基本は

User-agent: *

Disallow:

Sitemap: https://maple-pjt.com/sitemap.xml

こんな感じでOK。

WordPressの例(管理画面はクロールさせたくない時)

WordPressは、勝手に作成してくれることがほとんどなので、自分で作ることは少ないのかな?と思います。ここでは例として挙げています。

User-agent: *

Disallow: /wp-admin/ (管理画面配下すべてクロール拒否、それ以外は許可)

Allow: /wp-admin/post.php (管理画面配下でも、「post.php」のみ許可)

User-agent: GPTBot (ChatGPTなどのクロールを拒否)

Disallow: /

Sitemap: https://○○○/sitemap.xml

ファイルの設置

robots.txtファイルをサイトのトップページに設置します。

FTPソフトなどを使用します。

ここでいうと「http://mapletc.net/robots.txt」になります。

記述内容確認に使われていた「robots.txtテスター」は現在ない

サーチコンソールにある「robots.txtレポート」のステータスで確認します。

反映されるまではタイムラグがあります。

最後に

robots.txtは、「サイトのURL/robots.txt」でみることができます。

大手サイトがどんな感じで書いてあるのか、覗いてみるのもありですね!